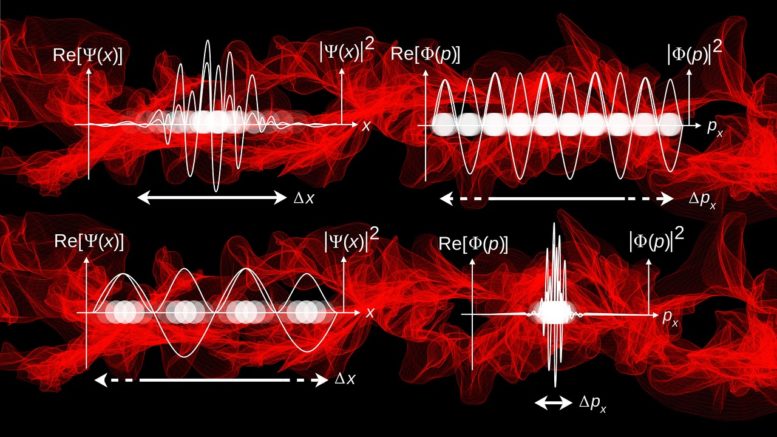

Kaum ein Thema wird in medialen Publikationen oftmals derart als der neue heilige Gral in Sachen Computertechnik präsentiert wie Quantencomputer. Gleichwohl sie in vielerlei Hinsicht noch in den Kinderschuhen stecken, werden sie von vielen als der essenzielle Paradigmenwechsel in Sachen Programmierung und Maschinensprache gesehen. Denn sie brechen mit dem binären System, auf das sich unsere bisherige Maschinensprache, und folglich auch alle Programmiersprachen, stützen. An Stelle der ewiglich binären Aneinanderreihung von ja/nein und wenn/dann Bedingungen sollen Qubits treten. Deren Besonderheit besteht im Gegensatz zu den binären Bits darin, dass sie quasi vollkommen fluide einen nummerischen Status zwischen 0 und 1 darstellen können, was eine ganz neue Art der Berechnung erlaubt. Und zwar eine, in der viele Wahrscheinlichkeiten simultan durchgespielt werden. Computerberechnung aus der Vogelperspektive der Szenarien anstatt des sequentiellen Einmaleins der konventionellen Berechnung.

Die Idee der Quantencomputer ist keineswegs neu. Bereits in den 1990er Jahren wurde ein erster Prototyp von IBM realisiert. Die grundsätzliche Machbarkeit und die wahrscheinlichsten Anwendungsfelder, in denen Quantencomputer konventionellen Computern theoretisch voraus sind, sind bereits bestens bekannt.

Quantencomputer sind grundsätzlich machbar, aber ….

In vielen Publikationen und Kommentaren auf Social Media und Co. entsteht nun das Bild, dass Quantencomputer drauf und dran wären, unsere regulären Computer im Staub der Geschichte zurückzulassen. Doch diese Einschätzung ist in mancherlei Hinsicht irreführend. Auch wenn Quantencomputer im Sinne eines „Proof of Concepts“ genauso funktionieren wie antizipiert, so sind sie aber auch noch nicht weit über dieses hinaus. Das Problem besteht nicht so sehr in der grundsätzlichen Machbarkeit, sondern in der Skalierbarkeit. Zuletzt wurden Quantencomputer mit über 100 Qubits erstmalig realisiert. Doch das ist immer noch extrem weit hinter dem, was es für kommerzielle Anwendung bräuchte (um eine Millionen stabiler (!) Qubits).

Qubits sind wesentlich störungsanfälliger durch Umgebungsfaktoren als konventionelle Hardware. Und je mehr Qubits gleichzeitig betrieben werden sollen, desto mehr verschärft sich das Problem. Man hat es also mit vielen Störgeräuschen zu tun, die teilweise extrem schwer zu bändigen sind. Dieses Problem ist als Quanten Dekohärenz bekannt und derart zwingend, dass man noch extrem weit davon entfernt ist, einen Quantencomputer mit etwa so vielen Qubits zu realisieren, sodass er als kommerzieller Quantencomputer genutzt und konventionelle Supercomputer verdrängen könnte.

Quantencomputer sind nur in gewissen Anwendungsfällen schneller

Doch selbst wenn Quantencomputer in diesen Größenordnungen irgendwann einmal gelingen; sie werden „normale“ Computer definitiv nicht komplett verdrängen. Noch nicht einmal annähernd! Schon gar nicht im Heimbereich und für viele kommerzielle Businessanwendungen. Denn Quantencomputer sind hoch spezialisiert. Ihre grundsätzlich andere Art der Berechnung ist für gewisse Anwendungsfälle extrem vorteilhaft. Beispielsweise wenn komplexe physikalische/chemische Zusammenhänge mit vielen simultanen Einflussfaktoren und unbekannten Variablen berechnet werden sollen.

Das gilt aber eben nur für logische Problemstellungen, die sich mit dieser Art der Berechnung besser bewältigen lassen. Viele bereits gelöste Probleme sind jedoch mittels normaler Programm- und Computerlogik bestens lösbar. In diesen Bereichen wird selbst ein vollentwickelter Quantencomputer kaum schneller, möglicherweise sogar langsamer sein. Denn auch ein Quantencomputer ist ein Werkzeug. Nicht weniger und nicht mehr, als dies auch für einen normalen Computer gilt. Und nicht alle Werkzeuge sind für alle Aufgabenstellungen gleich gut geeignet. Einen Hut setzt man sich ja auch nicht mit Hilfe eines Gabelstaplers auf.

Kein Formfaktor für das heimische Wohnzimmer

Problematisch ist wie gesagt die Skalierung der Rechenleistung. Auch weil sie räumliche sowie physikalische Tatsachen schafft. Denn Quantencomputer müssen viel intensiver gekühlt werden als reguläre Computer. Ein Paar Lüfter mehr reichen dafür nicht aus. Allein schon damit die Qubits stabil und möglichst unempfänglich für thermodynamische Störfaktoren aus der Umgebung bleiben, sind Temperaturen um den absoluten Nullpunkt (etwa -273 Grad Celsius) notwendig!

Wie zwingend das Problem der Skalierbarkeit ist, wird einem auch dann klar, wenn man sich die Hardware und ihre Dimensionen anschaut. Quantencomputer sind selbst jetzt, wo sie noch weitab der erwünschten Qubit Stärke sind, eine echte Monstrosität, die an die Zeiten erinnert, in denen Computer ganze Räume füllten und mittels Vakuumröhren ihre Schaltkreise regulierten. Sie sind gewaltig! Und die Transistoren, deren stetig kleiner werdende Dimensionen der Hauptgrund dafür sind, warum unsere Geräte immer kleiner, sparsamer und doch weit leistungsstärker wurden, können nicht viel weiter schrumpfen. Sie sind schon jetzt mikroskopisch klein und in Quantencomputern solcherart integriert – was deren Dimensionen keinen Abbruch tut. Wie viel kleiner Quantencomputer also noch werden können, auch eingedenk ihrer exorbitanten Anforderungen an die Umgebung, bleibt fraglich.

Prinzipielle Machbarkeit ist noch keine praktische Anwendbarkeit

Alles in allem sind Quantencomputer in einer ähnlichen Situation wie Fusionsreaktoren. Die prinzipielle Machbarkeit ist zweifelsohne erwiesen. Doch das Ganze soweit zu skalieren, dass es praktisch im angedachten Maßstab nutzbar wird, ist eine ganz andere Hausnummer! Insbesondere weil kaum eine Vorstellung davon besteht, wie höhere Programmiersprachen für Quantencomputer überhaupt aussehen könnten. Hier haben klassische Computer den Vorteil, dass die rigide Chronologie einer rein sequentiellen Berechnung weit intuitiver zu programmieren ist, als die vollkommen offene Berechnungslogik von Quantencomputern – und für die meisten Anwendungsfälle auch vollkommen ausreicht.